7.3 Projekt Linked swissbib

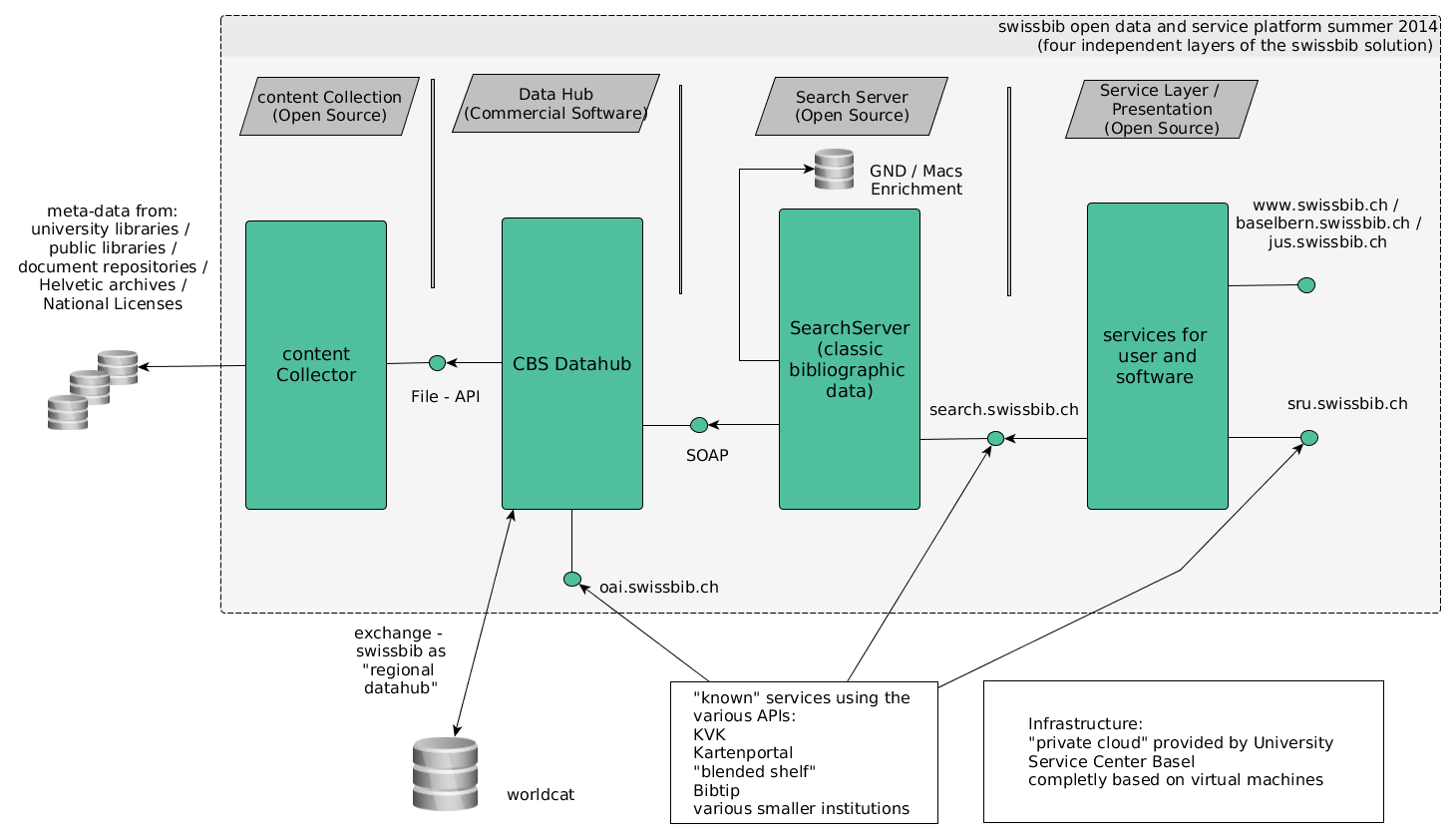

Swissbib Architektur

Die Grafik zeigt die Systemarchitektur von swissbib im Jahre 2014, bevor das Projekt Linked swissbib gestartet ist. Besonderer Wert wurde auf die Trennung verschiedener Layer gelegt, die über Schnittstellen miteinander interagieren. Dadurch wurde es möglich, kommerzielle Software (OCLC CBS) mit Open-Source-Software zu mischen.

Ziele von linked.swissbib

- Konversion des swissbib data sets in ein RDF Datenmodell (als Grundlage für Datenverknüpfungen)

- Nutze die Möglichkeiten von verlinkten Informationen in eigenen Services und biete sie anderen zur Nachnutzung an

- Verwendung von freier (möglichst erprobter) Software, entwickelt durch vergleichbare Institutionen. Entwicklungen sollten durch andere nachgenutzt werden können

Das Projekt startete 2014 als das Thema Linked Data für Bibliotheken noch vergleichsweise neu war und überwiegend theoretisch diskutiert wurde. Swissbib war prädestiniert für einen Praxistest, weil das Datenset von Swissbib schon umfassend ist und verschiedene Datenquellen beinhaltet. Die Nachnutzung der Projektergebnisse von linked swissbib für die Produktivumgebung von swissbib war von Beginn an ein erklärtes Ziel.

Das Projekt wurde von swissuniversities gefördert und gemeinsam von drei Partnern durchgeführt:

- Haute école de gestion de Genève: Schwerpunkt Datengenerierung

- Hochschule für Technik und Wirtschaft Chur: Schwerpunkt Oberfläche

- Universitätsbibliothek Basel: Schwerpunkt Infrastruktur

Resultate

Datentransformation

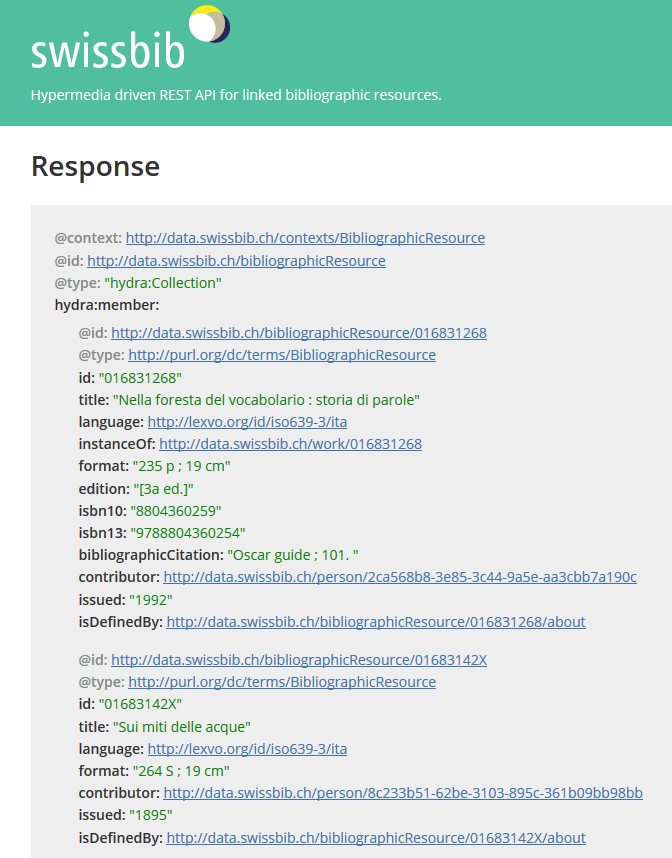

Aus etwa 29 Mio. MARC Aufnahmen wurden etwa 125 Mio. Dokumente in JSON-LD generiert, die in 6 Konzepte aufgeteilt sind:

- Bibliographic Resource

- Document

- Item

- Work

- Person

- Organisation

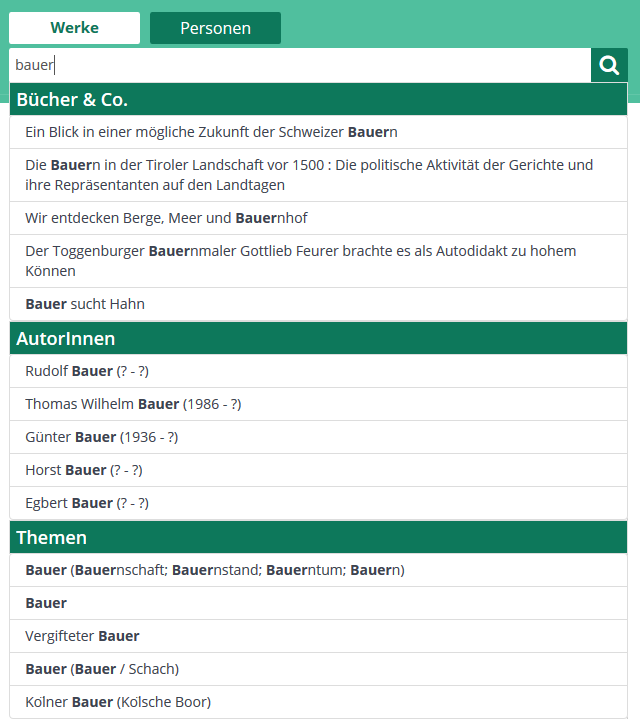

Suche

Personenseiten

RESTful API

CC-0 Daten stehen unter der Adresse http://data.swissbib.ch zur Nachnutzung zur Verfügung.

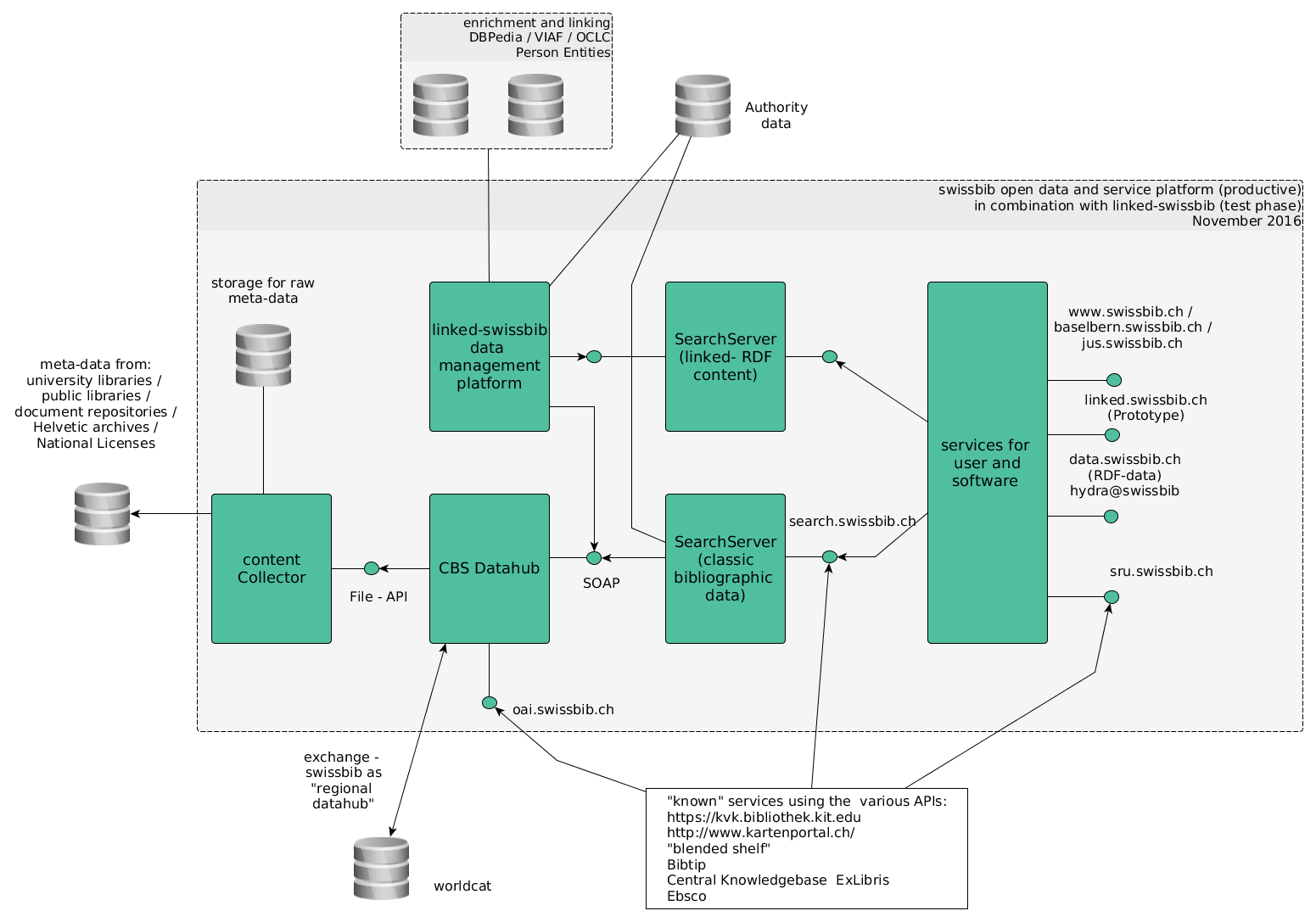

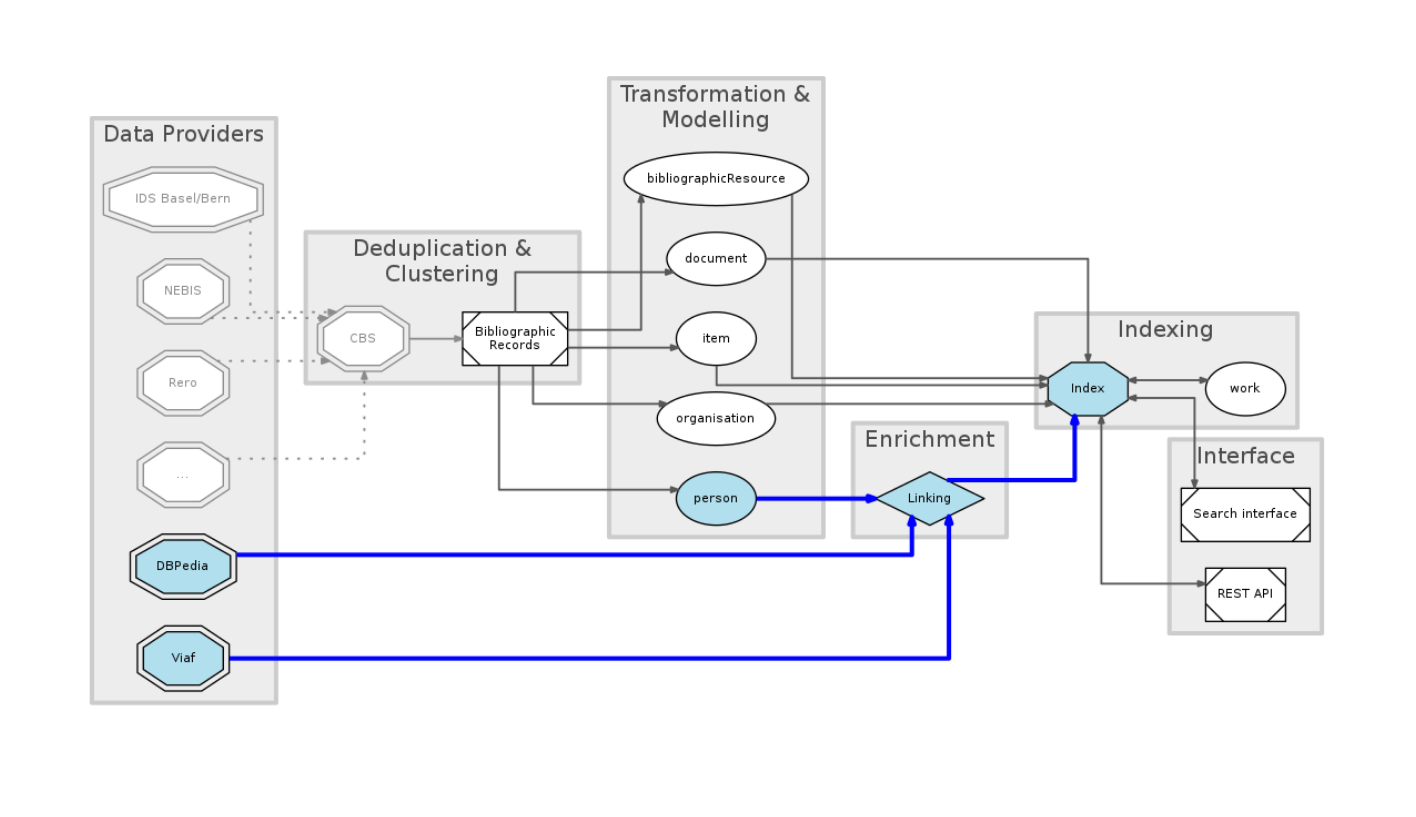

Systemarchitektur mit linked.swissbib

Die folgende Grafik zeigt die Systemarchitektur von swissbib inklusive der neuen Komponenten von linked.swissbib. Anstelle eines üblichen SPARQL-Endpoints wurde eine eigene RESTFUL API auf Basis von Elasticsearch implementiert.

Workflow und Komponenten

- Die Datentransformation erfolgt mit Metafacture, zukünftig ergänzt um die Big-Data-Technologie Spark (dazu mehr in Kap. 7.4).

- Die Anreicherung erfolgt mit LIMES (dazu mehr in Kap. 7.6).

- Die Daten werden in einem Elasticsearch-Suchindex lokal gespeichert. Mehr Informationen zur Verwendung von Elastic Search ist einem Vortrag auf einem Meetup vom August 2016 zu entnehmen (vgl. Video und Folien)